フレーム単位での行動認識結果のデモをFlaskを用いてデプロイ

Demo for action segmentation

動画認識デモについて

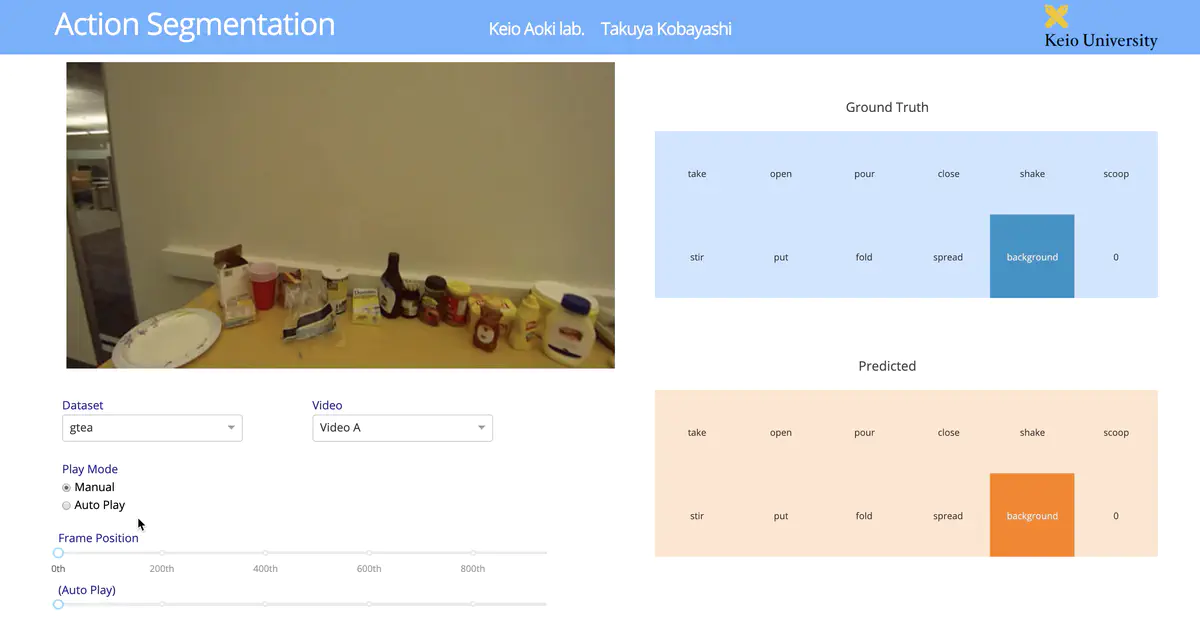

今まで作成したデモを汎用的に利用するために,最低限の機能のみに簡略化したデモを作成したので,使い方の手順とともに軽く説明していきたい。 まずはデモの実際の様子を以下に示した。フレーム単位での正解ラベルと予測ラベルを見ることができ,また手動でフレームを選ぶか自動再生するかの2つのモードを切り替えられる。

実行までの流れ

次に使い方についても軽く説明していきたい。

➊

まずはコードを公開しているGitHubページに移動し,gitレポジトリのクローンを行う。。

$ git clone [リポジトリ名]

➋

gitレポジトリには実際に試すためのサンプルデータ(動画,正解ラベル,認識結果)は載せていないため,別にデータをダウンロードしてもらう必要がある。URL先のzipファイル(Assets内のdatas.zip)を解凍し,app.pyと同じ階層にdatasファイルが来るように配置する(元々あるdatasファイルと置き換える)。今回はサンプルデータとしてgteaデータセットを用いている。

➌

必要なコードとデータは揃ったので,最後にアプリを動かすために必要なパッケージのインストールを行う。

$ pip install -r requirements.txt

➍

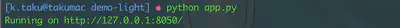

以上で準備は整ったので,アプリを実行する。

$ python app.py

➎

“Running on [ローカルのURL] “,といったメッセージが表示されるので,指定されたURLを開けばアプリが実行されていることが確認できる。

最後に

Demo結果の様子だけ見たい場合はリンク先にあります。 フレームレートがまだまだ遅いので(Google App Engine の仮想マシン環境の影響もある),より快適な可視化の為に改善をしていきたいとは思っている。